mongodb副本集

mongodb副本集

# Replica Sets

# 1.1 简介

MongoDB中的副本集(Replica Set)是一组维护相同数据集的mongod服务。 副本集可提供冗余和高可用性,是所有生产部署的基础。

也可以说,副本集类似于有自动故障恢复功能的主从集群。通俗的讲就是用多台机器进行同一数据的异步同步,从而使多台机器拥有同一数据的多个副本,并且当主库当掉时在不需要用户干预的情况下自动切换其他备份服务器做主库。而且还可以利用副本服务器做只读服务器,实现读写分离,提高负载。

(1)冗余和数据可用性

复制提供冗余并提高数据可用性。 通过在不同数据库服务器上提供多个数据副本,复制可提供一定级别的容错功能,以防止丢失单个数据库服务器。

在某些情况下,复制可以提供增加的读取性能,因为客户端可以将读取操作发送到不同的服务上, 在不同数据中心维护数据副本可以增加分布式应用程序的数据位置和可用性。 您还可以为专用目的维护其他副本,例如灾难恢复,报告或备份。

(2)MongoDB中的复制

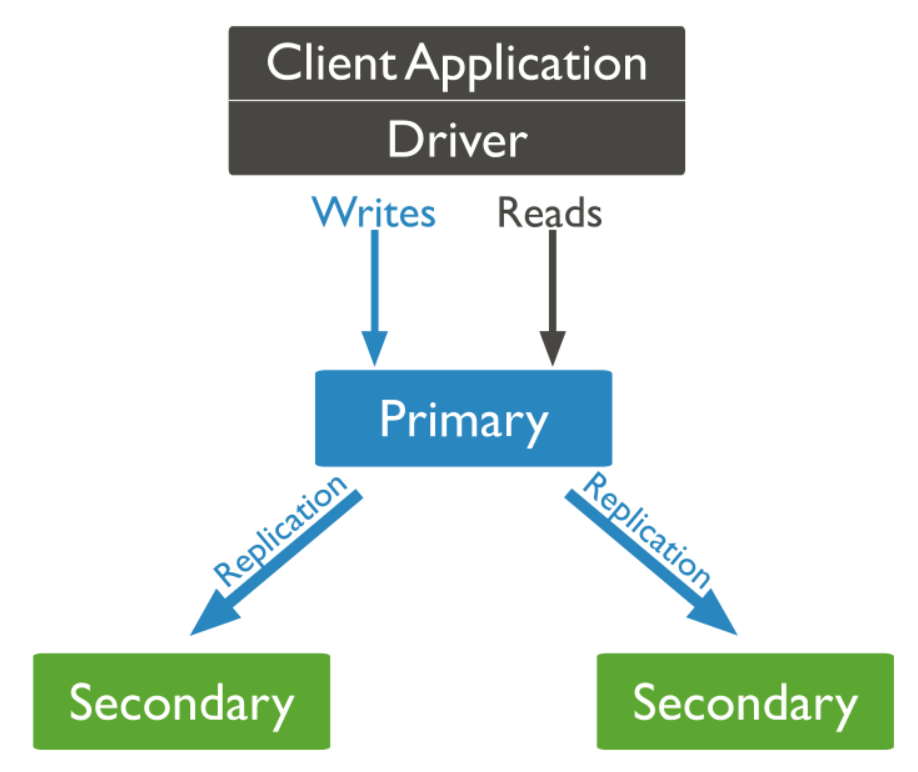

副本集是一组维护相同数据集的mongod实例。 副本集包含多个数据承载节点和可选的一个仲裁节点。在承载数据的节点中,一个且仅一个成员被视为主节点,而其他节点被视为次要(从)节点。

主节点接收所有写操作。 副本集只能有一个主要能够确认具有{w:“most”}写入关注的写入; 虽然在某些情况下,另一个mongod实例可能暂时认为自己也是主要的。主要记录其操作日志中的数据集的所有更改,即oplog。

辅助(副本)节点复制主节点的oplog并将操作应用于其数据集,以使辅助节点的数据集反映主节点的数据集。 如果主要人员不在,则符合条件的中学将举行选举以选出新的主要人员。

(3)主从复制和副本集区别

主从集群和副本集最大的区别就是副本集没有固定的“主节点”;整个集群会选出一个“主节点”,当其挂掉后,又在剩下的从节点中选中其他节点为“主节点”,副本集总有一个活跃点(主、primary)和一个或多个备份节点(从、secondary)。

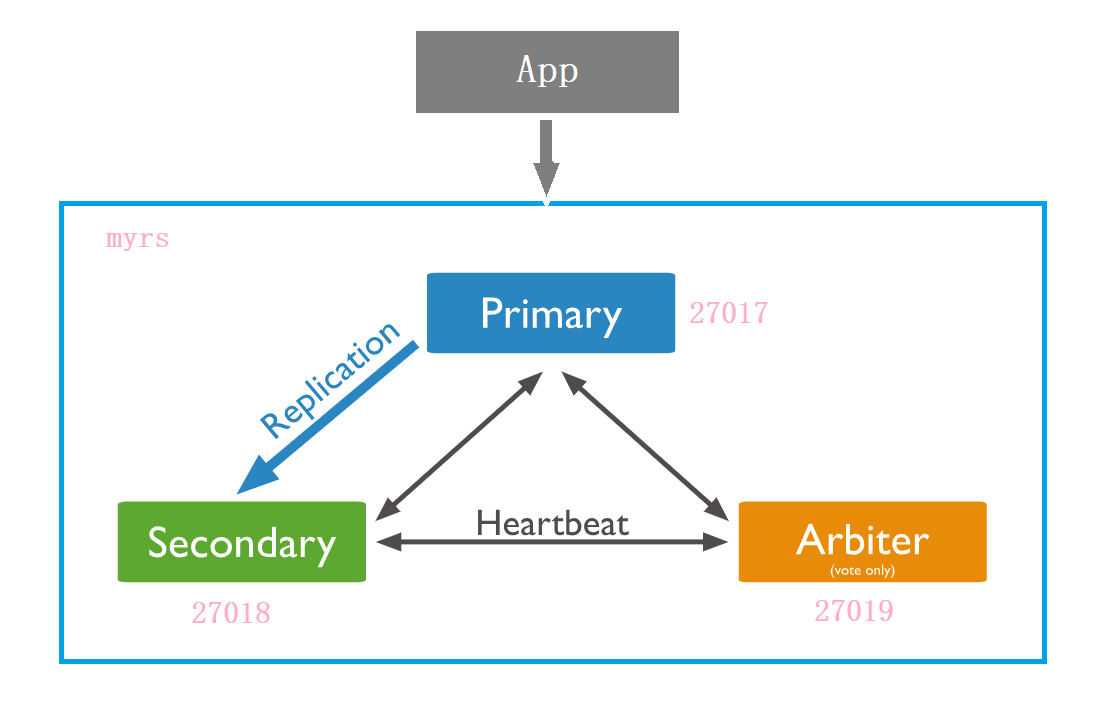

# 1.2 副本集的三个角色

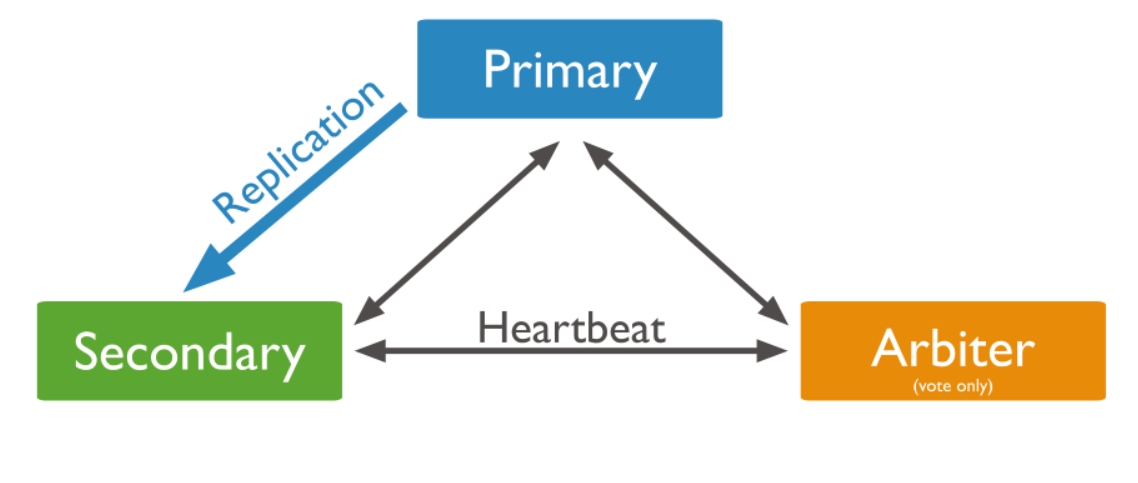

副本集有两种类型三种角色

两种类型:

- 主节点( Primary)类型:数据操作的主要连接点,可读写。

- 次要(辅助、从)节点( Secondaries)类型:数据冗余备份节点,可以读或选举。

三种角色:

- 主要成员(Primary):主要接收所有写操作。就是主节点。

- 副本成员(Replicate):从主节点通过复制操作以维护相同的数据集,即备份数据,不可写操作,但可以读操作(但需要配置)。是默认的一种从节点类型。

- 仲裁者( Arbiter):不保留任何数据的副本,只具有投票选举作用。当然也可以将仲裁服务器维护为副本集的一部分,即副本成员同时也可以是仲裁者。也是一种从节点类型。

关于仲裁者的额外说明:

您可以将额外的mongod实例添加到副本集作为仲裁者。 仲裁者不维护数据集。 仲裁者的目的是通过响应其他副本集成员的心跳和选举请求来维护副本集中的仲裁。 因为它们不存储数据集,所以仲裁器可以是提供副本集仲裁功能的好方法,其资源成本比具有数据集的全功能副本集成员更便宜。

如果您的副本集具有偶数个成员,请添加仲裁者以获得主要选举中的“大多数”投票。 仲裁者不需要专用硬件。

仲裁者将永远是仲裁者,而主要人员可能会退出并成为次要人员,而次要人员可能成为选举期间的主要人员。

如果你的副本+主节点的个数是偶数,建议加一个仲裁者,形成奇数,容易满足大多数的投票。

如果你的副本+主节点的个数是奇数,可以不加仲裁者。

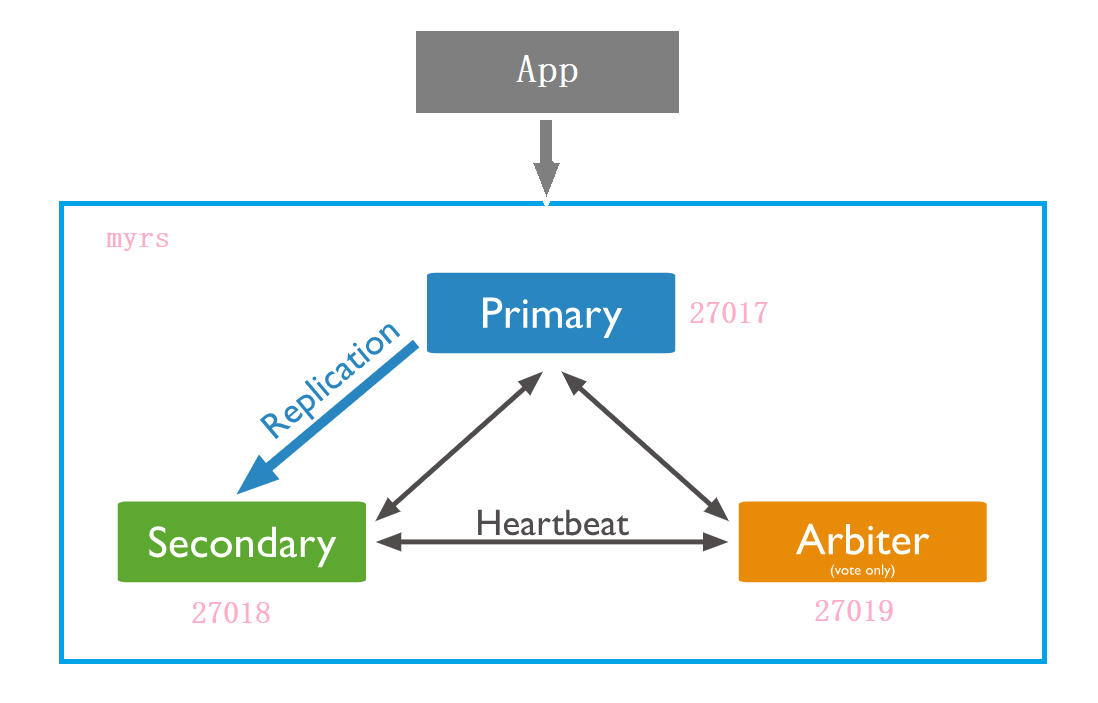

# 1.3 副本集架构目标

一主一副本一仲裁

# 1.4 副本集的创建

# 1.4.1 第一步:创建主节点

建立存放数据和日志的目录

#-----------myrs

#主节点

mkdir -p /mongodb/replica_sets/myrs_27017/log \ &

mkdir -p /mongodb/replica_sets/myrs_27017/data/db

2

3

4

新建或修改配置文件:

vim /mongodb/replica_sets/myrs_27017/mongod.conf

myrs_27017 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/replica_sets/myrs_27017/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/replica_sets/myrs_27017/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/replica_sets/myrs_27017/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27017

replication:

#副本集的名称

replSetName: myrs

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

启动节点服务:

[root@bobohost replica_sets]# /usr/local/mongodb/bin/mongod -f /mongodb/replica_sets/myrs_27017/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 54257

child process started successfully, parent exiting

2

3

4

# 1.4.2 第二步:创建副本节点

建立存放数据和日志的目录

#-----------myrs

#副本节点

mkdir -p /mongodb/replica_sets/myrs_27018/log \ &

mkdir -p /mongodb/replica_sets/myrs_27018/data/db

2

3

4

新建或修改配置文件:

vim /mongodb/replica_sets/myrs_27018/mongod.conf

myrs_27018 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/replica_sets/myrs_27018/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/replica_sets/myrs_27018/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/replica_sets/myrs_27018/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27018

replication:

#副本集的名称

replSetName: myrs

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

启动节点服务:

[root@bobohost replica_sets]# /usr/local/mongodb/bin/mongod -f /mongodb/replica_sets/myrs_27018/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 54361

child process started successfully, parent exiting

2

3

4

# 1.4.3 第三步:创建仲裁节点

建立存放数据和日志的目录

#-----------myrs

#仲裁节点

mkdir -p /mongodb/replica_sets/myrs_27019/log \ &

mkdir -p /mongodb/replica_sets/myrs_27019/data/db

2

3

4

新建或修改配置文件:

vim /mongodb/replica_sets/myrs_27019/mongod.conf

myrs_27019 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/replica_sets/myrs_27019/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/replica_sets/myrs_27019/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/replica_sets/myrs_27019/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27019

replication:

#副本集的名称

replSetName: myrs

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

启动节点服务:

[root@bobohost replica_sets]# /usr/local/mongodb/bin/mongod -f /mongodb/replica_sets/myrs_27019/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 54410

child process started successfully, parent exiting

2

3

4

# 1.4.4 第四步:初始化配置副本集和主节点

使用客户端命令连接任意一个节点,但这里尽量要连接主节点(27017节点):

/usr/local/mongodb/bin/mongo --host=180.76.159.126 --port=27017

结果,连接上之后,很多命令无法使用,,比如 show dbs 等,必须初始化副本集才行

准备初始化新的副本集:

语法:

rs.initiate(configuration)

【示例】

使用默认的配置来初始化副本集:

rs.initiate()

执行结果:

> rs.initiate()

{

"info2" : "no configuration specified. Using a default configuration for the set",

"me" : "180.76.159.126:27017",

"ok" : 1,

"operationTime" : Timestamp(1565760476, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565760476, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

myrs:SECONDARY>

myrs:PRIMARY>

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

提示:

- “ok”的值为1,说明创建成功。

- 命令行提示符发生变化,变成了一个从节点角色,此时默认不能读写。稍等片刻,回车,变成主节点。

# 1.4.5 第五步:查看副本集的配置内容

返回包含当前副本集配置的文档。

语法:

rs.conf(configuration)

提示:

rs.config() 是该方法的别名。

configuration:可选,如果没有配置,则使用默认主节点配置。

【示例】

在27017上执行副本集中当前节点的默认节点配置

myrs:PRIMARY> rs.conf()

{

"_id" : "myrs",

"version" : 1,

"protocolVersion" : NumberLong(1),

"writeConcernMajorityJournalDefault" : true,

"members" : [

{

"_id" : 0,

"host" : "180.76.159.126:27017",

"arbiterOnly" : false,

"buildIndexes" : true,

"hidden" : false,

"priority" : 1,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

}

],

"settings" : {

"chainingAllowed" : true,

"heartbeatIntervalMillis" : 2000,

"heartbeatTimeoutSecs" : 10,

"electionTimeoutMillis" : 10000,

"catchUpTimeoutMillis" : -1,

"catchUpTakeoverDelayMillis" : 30000,

"getLastErrorModes" : {

},

"getLastErrorDefaults" : {

"w" : 1,

"wtimeout" : 0

},

"replicaSetId" : ObjectId("5d539bdcd6a308e600d126bb")

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

说明:

"_id" : "myrs":副本集的配置数据存储的主键值,默认就是副本集的名字"members":副本集成员数组,此时只有一个: “host” : “180.76.159.126:27017” ,该成员不是仲裁节点:”arbiterOnly” : false ,优先级(权重值): “priority” : 1,"settings":副本集的参数配置。

提示:副本集配置的查看命令,本质是查询的是 system.replset 的表中的数据:

myrs:PRIMARY> use local

switched to db local

myrs:PRIMARY> show collections

oplog.rs

replset.election

replset.minvalid

replset.oplogTruncateAfterPoint

startup_log

system.replset

system.rollback.id

myrs:PRIMARY> db.system.replset.find()

{ "_id" : "myrs", "version" : 1, "protocolVersion" : NumberLong(1),

"writeConcernMajorityJournalDefault" : true, "members" : [ { "_id" : 0, "host" :

"180.76.159.126:27017", "arbiterOnly" : false, "buildIndexes" : true, "hidden" :

false, "priority" : 1, "tags" : { }, "slaveDelay" : NumberLong(0), "votes" : 1

} ], "settings" : { "chainingAllowed" : true, "heartbeatIntervalMillis" : 2000,

"heartbeatTimeoutSecs" : 10, "electionTimeoutMillis" : 10000,

"catchUpTimeoutMillis" : -1, "catchUpTakeoverDelayMillis" : 30000,

"getLastErrorModes" : { }, "getLastErrorDefaults" : { "w" : 1, "wtimeout" : 0

}, "replicaSetId" : ObjectId("5d539bdcd6a308e600d126bb") } }

myrs:PRIMARY>

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

# 1.4.6 第六步:查看副本集状态

检查副本集状态。

说明:

返回包含状态信息的文档。此输出使用从副本集的其他成员发送的心跳包中获得的数据反映副本集的当前状态。

语法:

rs.status()

【示例】

在27017上查看副本集状态:

myrs:PRIMARY> rs.status()

{

"set" : "myrs",

"date" : ISODate("2019-08-14T05:29:45.161Z"),

"myState" : 1,

"term" : NumberLong(1),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"heartbeatIntervalMillis" : NumberLong(2000),

"optimes" : {

"lastCommittedOpTime" : {

"ts" : Timestamp(1565760578, 1),

"t" : NumberLong(1)

},

"readConcernMajorityOpTime" : {

"ts" : Timestamp(1565760578, 1),

"t" : NumberLong(1)

},

"appliedOpTime" : {

"ts" : Timestamp(1565760578, 1),

"t" : NumberLong(1)

},

"durableOpTime" : {

"ts" : Timestamp(1565760578, 1),

"t" : NumberLong(1)

}

},

"lastStableCheckpointTimestamp" : Timestamp(1565760528, 1),

"members" : [

{

"_id" : 0,

"name" : "180.76.159.126:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 419,

"optime" : {

"ts" : Timestamp(1565760578, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-08-14T05:29:38Z"),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"infoMessage" : "could not find member to sync from",

"electionTime" : Timestamp(1565760476, 2),

"electionDate" : ISODate("2019-08-14T05:27:56Z"),

"configVersion" : 1,

"self" : true,

"lastHeartbeatMessage" : ""

}

],

"ok" : 1,

"operationTime" : Timestamp(1565760578, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565760578, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

说明:

"set" : "myrs":副本集的名字"myState": 1:说明状态正常"members":副本集成员数组,此时只有一个:"name" : "180.76.159.126:27017",该成员的角色是"stateStr" : "PRIMARY", 该节点是健康的:"health" : 1。

# 1.4.7 第七步:添加副本从节点

在主节点添加从节点,将其他成员加入到副本集

语法:

rs.add(host, arbiterOnly)

选项:

| Parameter | Type | Description |

|---|---|---|

| host | string or document | 要添加到副本集的新成员。 指定为字符串或配置文档:1)如果是一个字符串,则需要指定新成员的主机名和可选的端口号;2)如果是一个文档,请指定在members数组中找到的副本集成员配置文档。 您必须在成员配置文档中指定主机字段。有关文档配置字段的说明,详见下方文档:“主机成员的配置文档” |

| arbiterOnly | boolean | 可选的。 仅在 值为字符串时适用。 如果为true,则添加的主机是仲裁者。 |

主机成员的配置文档:

{

_id: <int>,

host: <string>, // required

arbiterOnly: <boolean>,

buildIndexes: <boolean>,

hidden: <boolean>,

priority: <number>,

tags: <document>,

slaveDelay: <int>,

votes: <number>

}

2

3

4

5

6

7

8

9

10

11

【示例】

将27018的副本节点添加到副本集中:

myrs:PRIMARY> rs.add("180.76.159.126:27018")

{

"ok" : 1,

"operationTime" : Timestamp(1565761757, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565761757, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

说明:

- “ok” : 1 :说明添加成功。

查看副本集状态:

myrs:PRIMARY> rs.status()

{

"set" : "myrs",

"date" : ISODate("2019-08-14T05:50:05.738Z"),

"myState" : 1,

"term" : NumberLong(1),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"heartbeatIntervalMillis" : NumberLong(2000),

"optimes" : {

"lastCommittedOpTime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"readConcernMajorityOpTime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"appliedOpTime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"durableOpTime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

}

},

"lastStableCheckpointTimestamp" : Timestamp(1565761798, 1),

"members" : [

{

"_id" : 0,

"name" : "180.76.159.126:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 1639,

"optime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-08-14T05:49:58Z"),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"infoMessage" : "",

"electionTime" : Timestamp(1565760476, 2),

"electionDate" : ISODate("2019-08-14T05:27:56Z"),

"configVersion" : 2,

"self" : true,

"lastHeartbeatMessage" : ""

},

{

"_id" : 1,

"name" : "180.76.159.126:27018",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 48,

"optime" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"optimeDurable" : {

"ts" : Timestamp(1565761798, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-08-14T05:49:58Z"),

"optimeDurableDate" : ISODate("2019-08-14T05:49:58Z"),

"lastHeartbeat" : ISODate("2019-08-14T05:50:05.294Z"),

"lastHeartbeatRecv" : ISODate("2019-08-

14T05:50:05.476Z"),

"pingMs" : NumberLong(0),

"lastHeartbeatMessage" : "",

"syncingTo" : "180.76.159.126:27017",

"syncSourceHost" : "180.76.159.126:27017",

"syncSourceId" : 0,

"infoMessage" : "",

"configVersion" : 2

}

],

"ok" : 1,

"operationTime" : Timestamp(1565761798, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565761798, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

说明:

"name" : "180.76.159.126:27018"是第二个节点的名字,其角色是"stateStr" : "SECONDARY"

# 1.4.8 第八步:添加仲裁从节点

添加一个仲裁节点到副本集

语法:

rs.addArb(host)

将27019的仲裁节点添加到副本集中:

myrs:PRIMARY> rs.addArb("180.76.159.126:27019")

{

"ok" : 1,

"operationTime" : Timestamp(1565761959, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565761959, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

说明:

"ok" : 1:说明添加成功。

查看副本集状态:

myrs:PRIMARY> rs.status()

{

"set" : "myrs",

"date" : ISODate("2019-08-14T05:53:27.198Z"),

"myState" : 1,

"term" : NumberLong(1),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"heartbeatIntervalMillis" : NumberLong(2000),

"optimes" : {

"lastCommittedOpTime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"readConcernMajorityOpTime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"appliedOpTime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"durableOpTime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

}

},

"lastStableCheckpointTimestamp" : Timestamp(1565761978, 1),

"members" : [

{

"_id" : 0,

"name" : "180.76.159.126:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 1841,

"optime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-08-14T05:53:18Z"),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"infoMessage" : "",

"electionTime" : Timestamp(1565760476, 2),

"electionDate" : ISODate("2019-08-14T05:27:56Z"),

"configVersion" : 3,

"self" : true,

"lastHeartbeatMessage" : ""

},

{

"_id" : 1,

"name" : "180.76.159.126:27018",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 249,

"optime" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"optimeDurable" : {

"ts" : Timestamp(1565761998, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-08-14T05:53:18Z"),

"optimeDurableDate" : ISODate("2019-08-14T05:53:18Z"),

"lastHeartbeat" : ISODate("2019-08-14T05:53:25.668Z"),

"lastHeartbeatRecv" : ISODate("2019-08-14T05:53:26.702Z"),

"pingMs" : NumberLong(0),

"lastHeartbeatMessage" : "",

"syncingTo" : "180.76.159.126:27017",

"syncSourceHost" : "180.76.159.126:27017",

"syncSourceId" : 0,

"infoMessage" : "",

"configVersion" : 3

},

{

"_id" : 2,

"name" : "180.76.159.126:27019",

"health" : 1,

"state" : 7,

"stateStr" : "ARBITER",

"uptime" : 47,

"lastHeartbeat" : ISODate("2019-08-14T05:53:25.668Z"),

"lastHeartbeatRecv" : ISODate("2019-08-14T05:53:25.685Z"),

"pingMs" : NumberLong(0),

"lastHeartbeatMessage" : "",

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"infoMessage" : "",

"configVersion" : 3

}

],

"ok" : 1,

"operationTime" : Timestamp(1565761998, 1),

"$clusterTime" : {

"clusterTime" : Timestamp(1565761998, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

说明:

"name" : "180.76.159.126:27019"是第二个节点的名字,其角色是"stateStr" : "ARBITER"

# 1.5 副本集的数据读写操作

目标:测试三个不同角色的节点的数据读写情况

登录主节点27017,写入和读取数据:

[root@bobohost ~]# /usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27017

myrs:PRIMARY> use articledb

switched to db articledb

myrs:PRIMARY> db

articledb

myrs:PRIMARY> db.comment.insert({"articleid":"100000","content":"今天天气真好,阳光明媚","userid":"1001","nickname":"Rose","createdatetime":new Date()})

WriteResult({ "nInserted" : 1 })

myrs:PRIMARY> db.comment.find()

{ "_id" : ObjectId("5d4d2ae3068138b4570f53bf"), "articleid" : "100000","content" : "今天天气真好,阳光明媚", "userid" : "1001", "nickname" : "Rose","createdatetime" : ISODate("2019-08-09T08:12:19.427Z") }

2

3

4

5

6

7

8

9

登录从节点27018

[root@bobohost ~]# /usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27018

myrs:SECONDARY> show dbs;

2019-09-10T10:56:51.953+0800 E QUERY [js] Error: listDatabases failed:{

"operationTime" : Timestamp(1568084204, 1),

"ok" : 0,

"errmsg" : "not master and slaveOk=false",

"code" : 13435,

"codeName" : "NotMasterNoSlaveOk",

"$clusterTime" : {

"clusterTime" : Timestamp(1568084204, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

} :

_getErrorWithCode@src/mongo/shell/utils.js:25:13

Mongo.prototype.getDBs@src/mongo/shell/mongo.js:139:1

shellHelper.show@src/mongo/shell/utils.js:882:13

shellHelper@src/mongo/shell/utils.js:766:15

@(shellhelp2):1:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

发现,不能读取集合的数据。当前从节点只是一个备份,不是奴隶节点,无法读取数据,写当然更不行。

因为默认情况下,从节点是没有读写权限的,可以增加读的权限,但需要进行设置

设置读操作权限:

说明:

设置为奴隶节点,允许在从成员上运行读的操作

语法:

rs.slaveOk()

#或

rs.slaveOk(true)

2

3

提示:

该命令是 db.getMongo().setSlaveOk() 的简化命令。

【示例】

在27018上设置作为奴隶节点权限,具备读权限:

rs:SECONDARY> rs.slaveOk()

此时,在执行查询命令,运行成功!

但仍然不允许插入。

myrs:SECONDARY> rs.slaveOk()

myrs:SECONDARY> show dbs;

admin 0.000GB

articledb 0.000GB

config 0.000GB

local 0.000GB

myrs:SECONDARY> use articledb

switched to db articledb

myrs:SECONDARY> show collections

comment

myrs:SECONDARY> db.comment.find()

{ "_id" : ObjectId("5d7710c04cfd7eee2e3cdabe"), "articleid" : "100000","content" : "今天天气真好,阳光明媚", "userid" : "1001", "nickname" : "Rose","createdatetime" : ISODate("2019-09-10T02:56:00.467Z") }

myrs:SECONDARY> db.comment.insert({"_id":"1","articleid":"100001","content":"我们不应该把清晨浪费在手机上,健康很重要,k一杯温水幸福你我他。","userid":"1002","nickname":"相忘于江湖","createdatetime":new Date("2019-08-05T22:08:15.522Z"),"likenum":NumberInt(1000),"state":"1"})

WriteCommandError({

"operationTime" : Timestamp(1568084434, 1),

"ok" : 0,

"errmsg" : "not master",

"code" : 10107,

"codeName" : "NotMaster",

"$clusterTime" : {

"clusterTime" : Timestamp(1568084434, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

})

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

现在可实现了读写分离,让主插入数据,让从来读取数据。

如果要取消作为奴隶节点的读权限:

myrs:SECONDARY> rs.slaveOk(false)

myrs:SECONDARY> db.comment.find()

Error: error: {

"operationTime" : Timestamp(1568084459, 1),

"ok" : 0,

"errmsg" : "not master and slaveOk=false",

"code" : 13435,

"codeName" : "NotMasterNoSlaveOk",

"$clusterTime" : {

"clusterTime" : Timestamp(1568084459, 1),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

仲裁者节点,不存放任何业务数据的,可以登录查看

[root@bobohost ~]# /usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27019

myrs:ARBITER> rs.slaveOk()

myrs:ARBITER> show dbs

local 0.000GB

myrs:ARBITER> use local

switched to db local

myrs:ARBITER> show collections

replset.minvalid

replset.oplogTruncateAfterPoint

startup_log

system.replset

system.rollback.id

myrs:ARBITER>

2

3

4

5

6

7

8

9

10

11

12

13

发现,只存放副本集配置等数据。

# 1.6 主节点的选举原则

MongoDB在副本集中,会自动进行主节点的选举,主节点选举的触发条件:

- 主节点故障

- 主节点网络不可达(默认心跳信息为10秒)

- 人工干预(rs.stepDown(600))

一旦触发选举,就要根据一定规则来选主节点。

选举规则是根据票数来决定谁获胜:

票数最高,且获得了 “大多数”成员的投票支持的节点获胜。

“大多数”的定义为:假设复制集内投票成员数量为N,则大多数为 N/2 + 1。例如:3个投票成员,则大多数的值是2。当复制集内存活成员数量不足大多数时,整个复制集将无法选举出Primary,复制集将无法提供写服务,处于只读状态。

若票数相同,且都获得了 “大多数”成员的投票支持的,数据新的节点获胜。

数据的新旧是通过操作日志oplog来对比的。

在获得票数的时候,优先级(priority)参数影响重大。

可以通过设置优先级(priority)来设置额外票数。优先级即权重,取值为0-1000,相当于可额外增加0-1000的票数,优先级的值越大,就越可能获得多数成员的投票(votes)数。指定较高的值可使成员更有资格成为主要成员,更低的值可使成员更不符合条件。

默认情况下,优先级的值是1

myrs:PRIMARY> rs.conf()

{

"_id" : "myrs",

"version" : 3,

"protocolVersion" : NumberLong(1),

"writeConcernMajorityJournalDefault" : true,

"members" : [

{

"_id" : 0,

"host" : "180.76.159.126:27017",

"arbiterOnly" : false,

"buildIndexes" : true,

"hidden" : false,

"priority" : 1,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

},

{

"_id" : 1,

"host" : "180.76.159.126:27018",

"arbiterOnly" : false,

"buildIndexes" : true,

"hidden" : false,

"priority" : 1,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

},

{

"_id" : 2,

"host" : "180.76.159.126:27019",

"arbiterOnly" : true,

"buildIndexes" : true,

"hidden" : false,

"priority" : 0,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

}

],

"settings" : {

"chainingAllowed" : true,

"heartbeatIntervalMillis" : 2000,

"heartbeatTimeoutSecs" : 10,

"electionTimeoutMillis" : 10000,

"catchUpTimeoutMillis" : -1,

"catchUpTakeoverDelayMillis" : 30000,

"getLastErrorModes" : {

},

"getLastErrorDefaults" : {

"w" : 1,

"wtimeout" : 0

},

"replicaSetId" : ObjectId("5d539bdcd6a308e600d126bb")

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

可以看出,主节点和副本节点的优先级各为 1,即,默认可以认为都已经有了一票。但选举节点,优先级是0,(要注意是,官方说了,选举节点的优先级必须是0,不能是别的值。即不具备选举权,但具有投票权)

【了解】修改优先级

比如,下面提升从节点的优先级:

1)先将配置导入cfg变量

myrs:SECONDARY> cfg=rs.conf()

2 )然后修改值(ID号默认从0开始)

myrs:SECONDARY> cfg.members[1].priority=2

2

2

3 )重新加载配置

myrs:SECONDARY> rs.reconfig(cfg)

{ "ok" : 1 }

2

稍等片刻会重新开始选举。

# 1.7 故障测试

# 1.7.1 副本节点故障测试

关闭27018副本节点:

发现,主节点和仲裁节点对27018的心跳失败。因为主节点还在,因此,没有触发投票选举。

如果此时,在主节点写入数据。

db.comment.insert({"_id":"1","articleid":"100001","content":"我们不应该把清晨浪费在手机上,健康很重要,一杯温水幸福你我他。","userid":"1002","nickname":"相忘于江湖","createdatetime":new Date("2019-08-05T22:08:15.522Z"),"likenum":NumberInt(1000),"state":"1"})

再启动从节点,会发现,主节点写入的数据,会自动同步给从节点。

# 1.7.2 主节点故障测试

关闭27017节点

发现,从节点和仲裁节点对27017的心跳失败,当失败超过10秒,此时因为没有主节点了,会自动发起投票。

而副本节点只有27018,因此,候选人只有一个就是27018,开始投票。

27019向27018投了一票,27018本身自带一票,因此共两票,超过了“大多数”

27019是仲裁节点,没有选举权,27018不向其投票,其票数是0.

最终结果,27018成为主节点。具备读写功能。

在27018写入数据查看。

db.comment.insert({"_id":"2","articleid":"100001","content":"我夏天空腹喝凉开水,冬天喝温开水","userid":"1005","nickname":"伊人憔悴","createdatetime":new Date("2019-08-05T23:58:51.485Z"),"likenum":NumberInt(888),"state":"1"})

再启动 27017节点,发现27017变成了从节点,27018仍保持主节点。

登录27017节点,发现是从节点了,数据自动从27018同步。

从而实现了高可用。

# 1.7.3 仲裁节点和主节点故障

先关掉仲裁节点27019,

关掉现在的主节点27018

登录27017后,发现,27017仍然是从节点,副本集中没有主节点了,导致此时,副本集是只读状态,无法写入。

为啥不选举了?因为27017的票数,没有获得大多数,即没有大于等于2,它只有默认的一票(优先级是1)

如果要触发选举,随便加入一个成员即可。

- 如果只加入 27019仲裁节点成员,则主节点一定是27017,因为没得选了,仲裁节点不参与选举,但参与投票。(不演示)

- 如果只加入 27018节点,会发起选举。因为27017和27018都是两票,则按照谁数据新,谁当主节点。

# 1.7.4 仲裁节点和从节点故障

先关掉仲裁节点27019,

关掉现在的副本节点27018

10秒后,27017主节点自动降级为副本节点。(服务降级)

副本集不可写数据了,已经故障了。

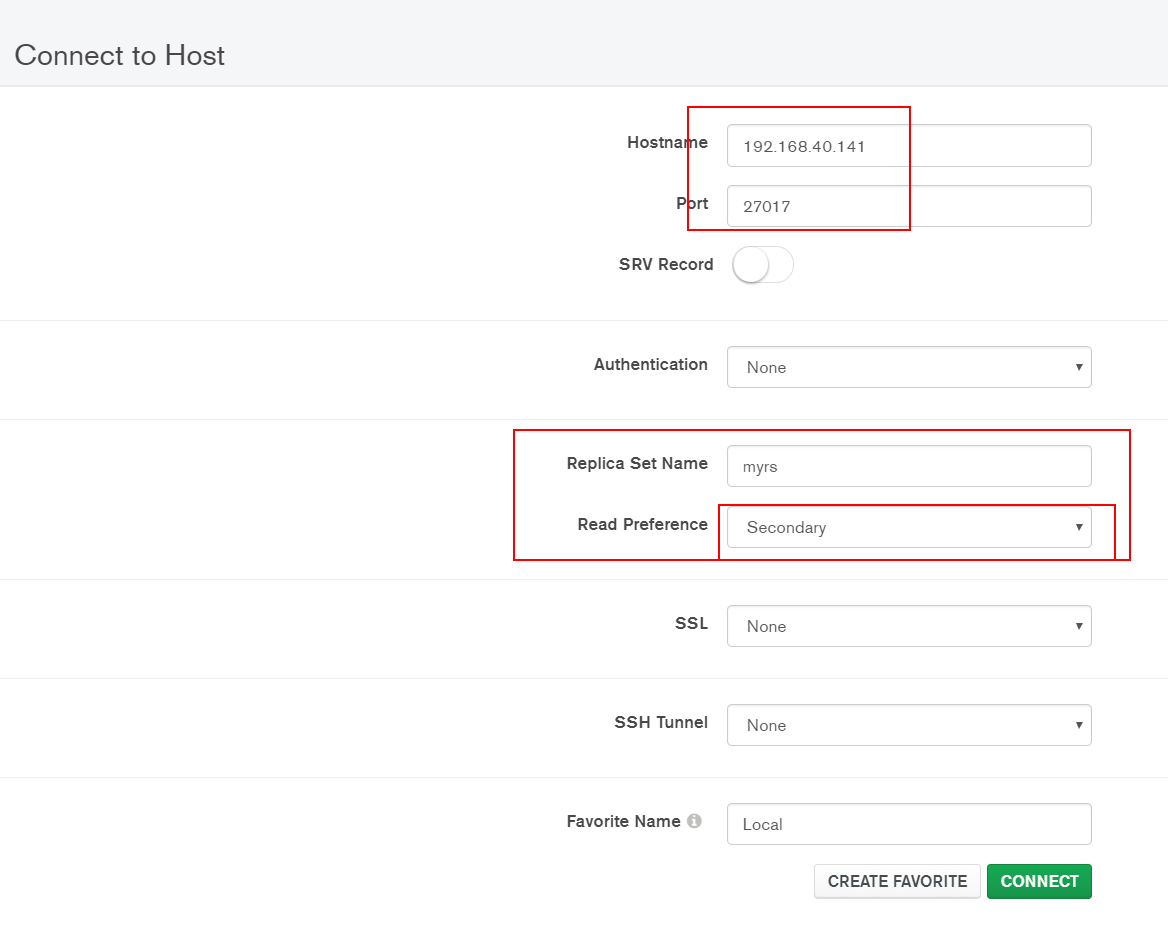

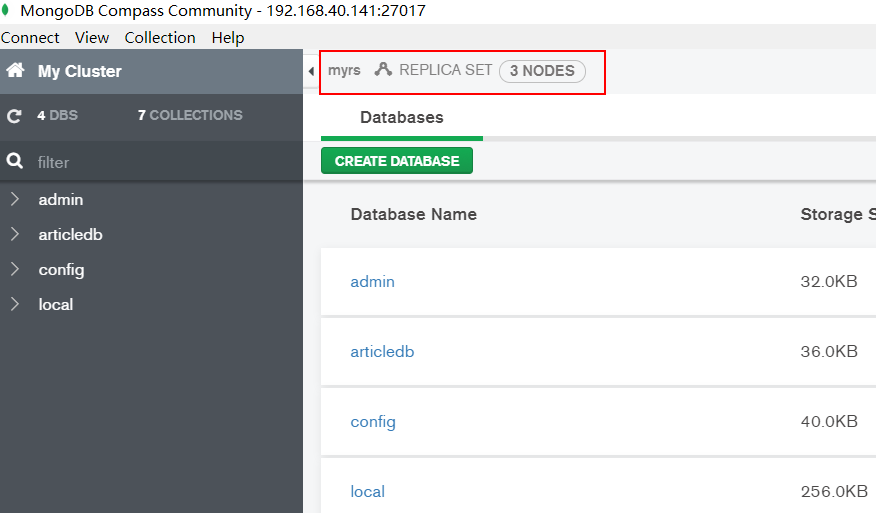

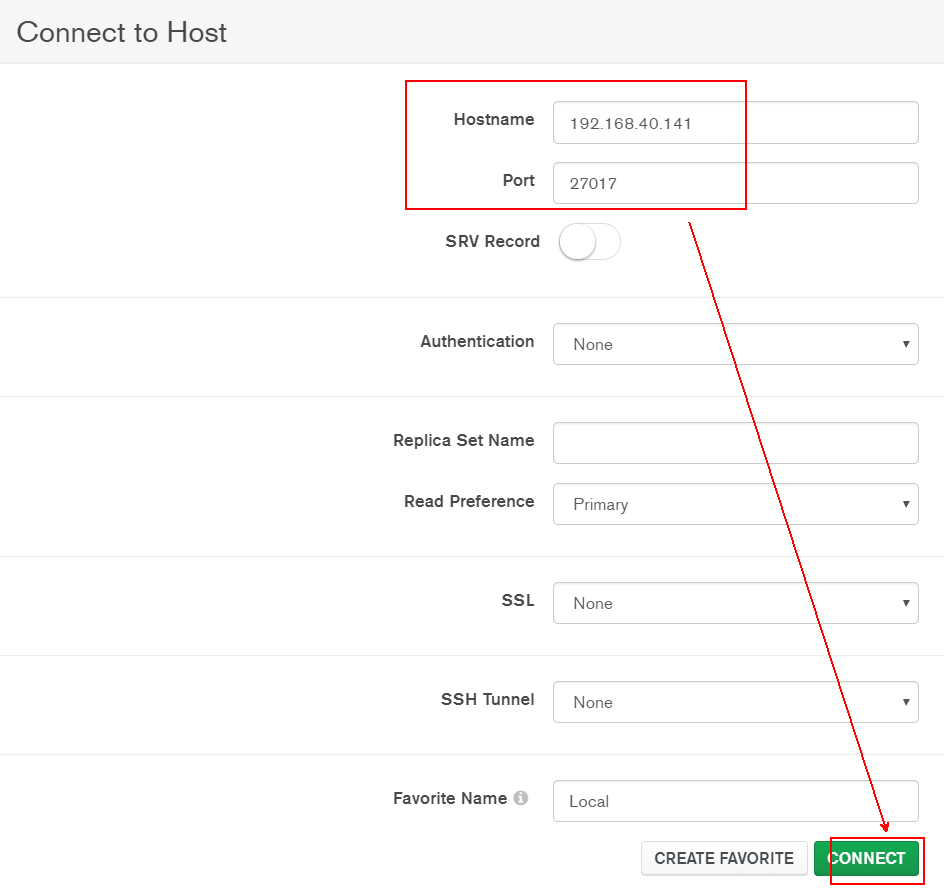

# 1.8 Compass 连接副本集

compass连接:

# 1.9 SpringDataMongoDB 连接副本集

副本集语法:

mongodb://host1,host2,host3/articledb?connect=replicaSet&slaveOk=true&replicaSet=副本集名字

其中:

- slaveOk=true :开启副本节点读的功能,可实现读写分离。

- connect=replicaSet :自动到副本集中选择读写的主机。如果slaveOK是打开的,则实现了读写分离

【示例】

连接 replica set 三台服务器 (端口 27017, 27018, 和27019),直接连接第一个服务器,无论是replica set一部分或者主服务器或者从服务器,写入操作应用在主服务器 并且分布查询到从服务器。

修改配置文件application.yml

spring:

#数据源配置

data:

mongodb:

# 主机地址

# host: 180.76.159.126

# 数据库

# database: articledb

# 默认端口是27017

# port: 27017

#也可以使用uri连接

#uri: mongodb://192.168.40.134:27017/articledb

# 副本集的连接字符串

uri: mongodb://180.76.159.126:27017,180.76.159.126:27018,180.76.159.126:27019/articledb?connect=replicaSet&slaveOk=true&replicaSet=myrs

2

3

4

5

6

7

8

9

10

11

12

13

14

注意:

主机必须是副本集中所有的主机,包括主节点、副本节点、仲裁节点。

SpringDataMongoDB自动实现了读写分离:

写操作时,只打开主节点连接;读操作是,同时打开主节点和从节点连接,但使用从节点获取数据。

完整的连接字符串的参考(了解):

MongoDB客户端连接语法:

mongodb://[username:password@]host1[:port1][,host2[:port2],...[,hostN[:portN]]][/[database][?options]]

- mongodb:// 这是固定的格式,必须要指定。

- username:password@ 可选项,如果设置,在连接数据库服务器之后,驱动都会尝试登陆这个数据库

- host1 必须的指定至少一个host, host1 是这个URI唯一要填写的。它指定了要连接服务器的地址。如果要连接复制集,请指定多个主机地址。

- portX 可选的指定端口,如果不填,默认为27017

- /database 如果指定username:password@,连接并验证登陆指定数据库。若不指定,默认打开test 数据库。

- ?options 是连接选项。如果不使用/database,则前面需要加上/。所有连接选项都是键值对name=value,键值对之间通过&或;(分号)隔开

标准的连接格式包含了多个选项(options),如下所示:

| 选项 | 描述 |

|---|---|

| replicaSet=name | 验证replica set的名称。 Impliesconnect=replicaSet. |

| slaveOk=true|false | true:在connect=direct模式下,驱动会连接第一台机器,即使这台服务器不是主。在connect=replicaSet模式下,驱动会发送所有的写请求到主并且把读取操作分布在其他从服务器。false: 在connect=direct模式下,驱动会自动找寻主服务器. 在connect=replicaSet 模式下,驱动仅仅连接主服务器,并且所有的读写命令都连接到主服务器。 |

| safe=true|false | true: 在执行更新操作之后,驱动都会发送getLastError命令来确保更新成功。(还要参考 wtimeoutMS).false: 在每次更新之后,驱动不会发送getLastError来确保更新成功。 |

| w=n | 驱动添加 { w : n } 到getLastError命令. 应用于safe=true。 |

| wtimeoutMS=ms | 驱动添加 { wtimeout : ms } 到 getlasterror 命令. 应用于 safe=true. |

| fsync=true|false | true: 驱动添加 { fsync : true } 到 getlasterror 命令.应用于safe=true.false: 驱动不会添加到getLastError命令中。 |

| journal=true|false | 如果设置为 true, 同步到 journal (在提交到数据库前写入到实体中).应用于 safe=true |

| connectTimeoutMS=ms | 可以打开连接的时间 |

| socketTimeoutMS=ms | 发送和接受sockets的时间 |

# 2. 分片集群-Sharded Cluster

# 2.1 分片概念

分片(sharding)是一种跨多台机器分布数据的方法, MongoDB使用分片来支持具有非常大的数据集和高吞吐量操作的部署。

换句话说:分片(sharding)是指将数据拆分,将其分散存在不同的机器上的过程。有时也用分区(partitioning)来表示这个概念。将数据分散到不同的机器上,不需要功能强大的大型计算机就可以储存更多的数据,处理更多的负载。

具有大型数据集或高吞吐量应用程序的数据库系统可以会挑战单个服务器的容量。例如,高查询率会耗尽服务器的CPU容量。工作集大小大于系统的RAM会强调磁盘驱动器的I / O容量。

有两种解决系统增长的方法:垂直扩展和水平扩展。

垂直扩展意味着增加单个服务器的容量,例如使用更强大的CPU,添加更多RAM或增加存储空间量。可用技术的局限性可能会限制单个机器对于给定工作负载而言足够强大。此外,基于云的提供商基于可用的硬件配置具有硬性上限。结果,垂直缩放有实际的最大值。

水平扩展意味着划分系统数据集并加载多个服务器,添加其他服务器以根据需要增加容量。虽然单个机器的总体速度或容量可能不高,但每台机器处理整个工作负载的子集,可能提供比单个高速大容量服务器更高的效率。扩展部署容量只需要根据需要添加额外的服务器,这可能比单个机器的高端硬件的总体成本更低。权衡是基础架构和部署维护的复杂性增加。

MongoDB支持通过分片进行水平扩展。

# 2.2 分片集群包含的组件

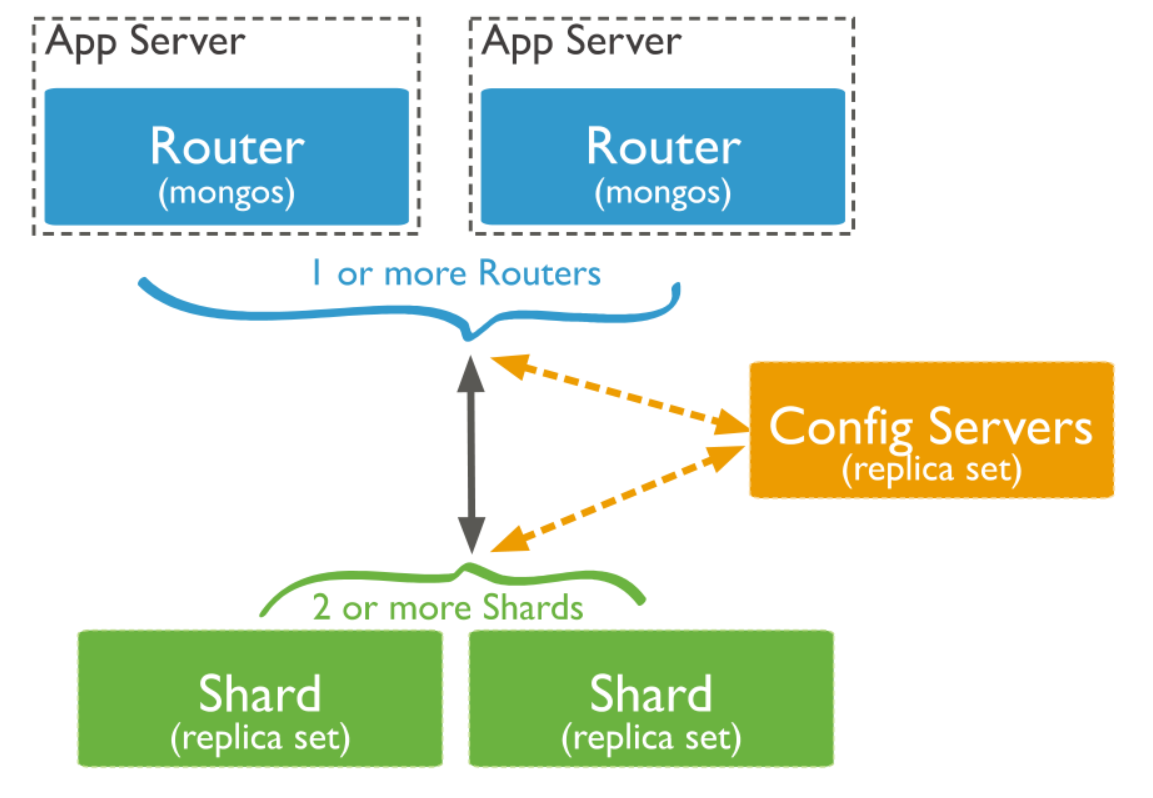

MongoDB分片群集包含以下组件:

- 分片(存储):每个分片包含分片数据的子集。 每个分片都可以部署为副本集。

- mongos (路由):mongos充当查询路由器,在客户端应用程序和分片集群之间提供接口。

- config servers (“调度”的配置):配置服务器存储群集的元数据和配置设置。 从MongoDB 3.4开始,必须将配置服务器部署为副本集(CSRS)。

下图描述了分片集群中组件的交互:

MongoDB在集合级别对数据进行分片,将集合数据分布在集群中的分片上。

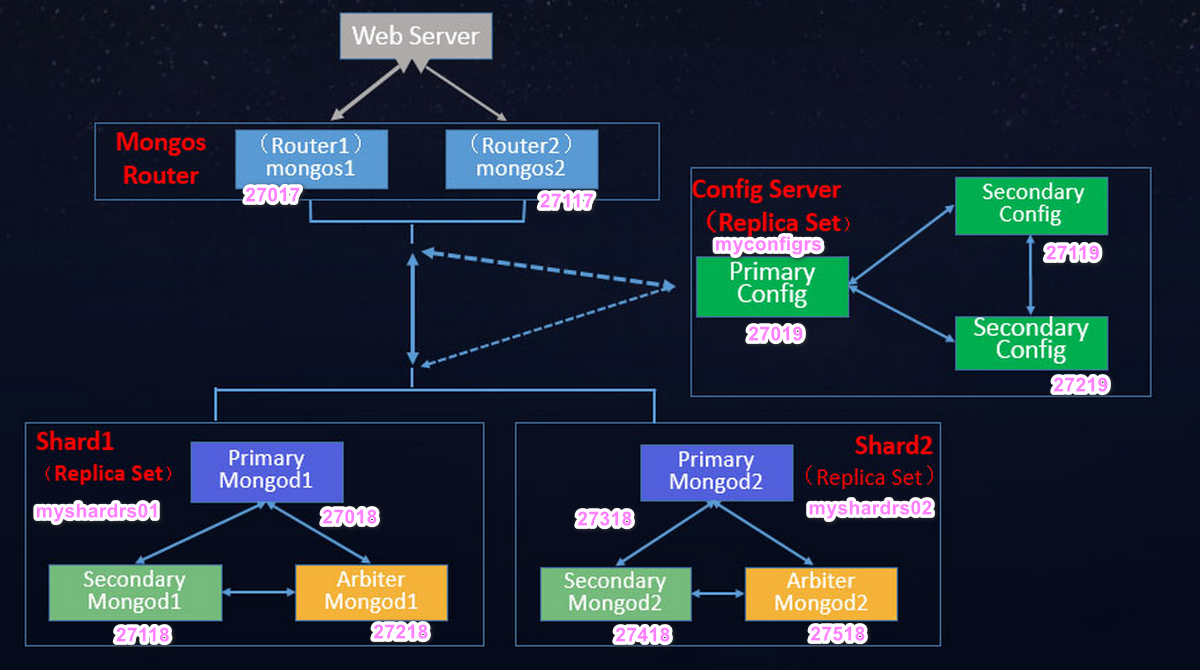

# 2.3 分片集群架构目标

两个分片节点副本集(3+3)+一个配置节点副本集(3)+两个路由节点(2),共11个服务节点。

# 2.4 分片(存储)节点副本集的创建

所有的的配置文件都直接放到 sharded_cluster 的相应的子目录下面,默认配置文件名字:mongod.conf

# 2.4.1 第一套副本集

准备存放数据和日志的目录:

#-----------myshardrs01

mkdir -p /mongodb/sharded_cluster/myshardrs01_27018/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs01_27018/data/db \ &

mkdir -p /mongodb/sharded_cluster/myshardrs01_27118/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs01_27118/data/db \ &

mkdir -p /mongodb/sharded_cluster/myshardrs01_27218/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs01_27218/data/db

2

3

4

5

6

7

8

9

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs01_27018/mongod.conf

myshardrs01_27018 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs01_27018/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs01_27018/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs01_27018/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27018

replication:

#副本集的名称

replSetName: myshardrs01

sharding:

#分片角色

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

sharding.clusterRole:

| Value | Description |

|---|---|

| configsvr | Start this instance as a config server. The instance starts on port 27019 by default. |

| shardsvr | Start this instance as a shard . The instance starts on port 27018 by default. |

注意:

设置sharding.clusterRole需要mongod实例运行复制。 要将实例部署为副本集成员,请使用replSetName设置并指定副本集的名称。

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs01_27118/mongod.conf

myshardrs01_27118 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs01_27118/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs01_27118/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs01_27118/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27118

replication:

replSetName: myshardrs01

sharding:

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs01_27218/mongod.conf

myshardrs01_27218 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs01_27218/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs01_27218/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs01_27218/log/mongod.pid"

net:

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27218

replication:

replSetName: myshardrs01

sharding:

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

启动第一套副本集:一主一副本一仲裁

依次启动三个mongod服务:

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27018/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123223

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27118/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123292

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27218/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123326

child process started successfully, parent exiting

2

3

4

5

6

7

8

9

10

11

12

13

14

查看服务是否启动:

[root@bobohost bin]# ps -ef |grep mongod

polkitd 61622 61604 0 7月31 ? 00:04:29 mongod --bind_ip_all

root 123223 1 1 01:10 ? 00:00:01 /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27018/mongod.conf

root 123292 1 4 01:11 ? 00:00:00 /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27118/mongod.conf

root 123326 1 6 01:11 ? 00:00:00 /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs01_27218/mongod.conf

2

3

4

5

# 2.4.1.1 初始化副本集和创建主节点:

使用客户端命令连接任意一个节点,但这里尽量要连接主节点:

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27018

执行初始化副本集命令:

rs.initiate()

查看副本集情况

rs.status()

主节点配置查看

rs.conf()

# 2.4.1.2 添加副本节点

rs.add("180.76.159.126:27118")

# 2.4.1.3 添加仲裁节点

rs.addArb("180.76.159.126:27218")

查看副本集的配置情况

myshardrs01:PRIMARY> rs.conf()

{

"_id" : "myshardrs01",

"version" : 3,

"protocolVersion" : NumberLong(1),

"writeConcernMajorityJournalDefault" : true,

"members" : [

{

"_id" : 0,

"host" : "180.76.159.126:27018",

"arbiterOnly" : false,

"buildIndexes" : true,

"hidden" : false,

"priority" : 1,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

},

{

"_id" : 1,

"host" : "180.76.159.126:27118",

"arbiterOnly" : false,

"buildIndexes" : true,

"hidden" : false,

"priority" : 1,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

},

{

"_id" : 2,

"host" : "180.76.159.126:27218",

"arbiterOnly" : true,

"buildIndexes" : true,

"hidden" : false,

"priority" : 0,

"tags" : {

},

"slaveDelay" : NumberLong(0),

"votes" : 1

}

],

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

# 2.4.2 第二套副本集

准备存放数据和日志的目录:

#-----------myshardrs02

mkdir -p /mongodb/sharded_cluster/myshardrs02_27318/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs02_27318/data/db \ &

mkdir -p /mongodb/sharded_cluster/myshardrs02_27418/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs02_27418/data/db \ &

mkdir -p /mongodb/sharded_cluster/myshardrs02_27518/log \ &

mkdir -p /mongodb/sharded_cluster/myshardrs02_27518/data/db

2

3

4

5

6

7

8

9

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs02_27318/mongod.conf

myshardrs02_27318 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs02_27318/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs02_27318/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs02_27318/log/mongod.pid"

net:

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27318

replication:

replSetName: myshardrs02

sharding:

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs02_27418/mongod.conf

myshardrs02_27418 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs02_27418/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs02_27418/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs02_27418/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27418

replication:

replSetName: myshardrs02

sharding:

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

新建或修改配置文件:

vim /mongodb/sharded_cluster/myshardrs02_27518/mongod.conf

myshardrs02_27518 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myshardrs02_27518/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myshardrs02_27518/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myshardrs02_27518/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27518

replication:

replSetName: myshardrs02

sharding:

clusterRole: shardsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

启动第二套副本集:一主一副本一仲裁

依次启动三个mongod服务:

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs02_27318/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123223

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs02_27418/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123292

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myshardrs02_27518/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123326

child process started successfully, parent exiting

2

3

4

5

6

7

8

9

10

11

12

13

14

查看服务是否启动:

[root@bobohost bin]# ps -ef |grep mongod

# 2.4.2.1 初始化副本集和创建主节点

使用客户端命令连接任意一个节点,但这里尽量要连接主节点:

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27318

执行初始化副本集命令:

rs.initiate()

查看副本集情况 (节选内容):

rs.status()

主节点配置查看:

rs.conf()

# 2.4.2.2 添加副本节点

rs.add("180.76.159.126:27418")

# 2.4.2.3 添加仲裁节点

rs.addArb("180.76.159.126:27518")

查看副本集的配置情况

myshardrs02:PRIMARY> rs.status()

{

"set" : "myshardrs02",

"date" : ISODate("2019-07-31T21:38:22.463Z"),

"myState" : 1,

"term" : NumberLong(1),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"heartbeatIntervalMillis" : NumberLong(2000),

"optimes" : {

"lastCommittedOpTime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"readConcernMajorityOpTime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"appliedOpTime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"durableOpTime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

}

},

"lastStableCheckpointTimestamp" : Timestamp(1564609074, 1),

"members" : [

{

"_id" : 0,

"name" : "180.76.159.126:27318",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 5086,

"optime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-07-31T21:38:14Z"),

"syncingTo" : "",

"syncSourceHost" : "",

"syncSourceId" : -1,

"infoMessage" : "",

"electionTime" : Timestamp(1564604032, 2),

"electionDate" : ISODate("2019-07-31T20:13:52Z"),

"configVersion" : 3,

"self" : true,

"lastHeartbeatMessage" : ""

},

{

"_id" : 1,

"name" : "180.76.159.126:27418",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 4452,

"optime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"optimeDurable" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-07-31T21:38:14Z"),

"optimeDurableDate" : ISODate("2019-07-31T21:38:14Z"),

"lastHeartbeat" : ISODate("2019-07-31T21:38:21.178Z"),

"lastHeartbeatRecv" : ISODate("2019-07-31T21:38:20.483Z"),

"pingMs" : NumberLong(0),

"lastHeartbeatMessage" : "",

"syncingTo" : "180.76.159.126:27518",

"syncSourceHost" : "180.76.159.126:27518",

"syncSourceId" : 2,

"infoMessage" : "",

"configVersion" : 3

},

{

"_id" : 2,

"name" : "180.76.159.126:27518",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 4448,

"optime" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"optimeDurable" : {

"ts" : Timestamp(1564609094, 1),

"t" : NumberLong(1)

},

"optimeDate" : ISODate("2019-07-31T21:38:14Z"),

"optimeDurableDate" : ISODate("2019-07-31T21:38:14Z"),

"lastHeartbeat" : ISODate("2019-07-31T21:38:21.178Z"),

"lastHeartbeatRecv" : ISODate("2019-07-31T21:38:22.096Z"),

"pingMs" : NumberLong(0),

"lastHeartbeatMessage" : "",

"syncingTo" : "180.76.159.126:27318",

"syncSourceHost" : "180.76.159.126:27318",

"syncSourceId" : 0,

"infoMessage" : "",

"configVersion" : 3

}

],

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

# 2.5 配置节点副本集的创建

第一步:准备存放数据和日志的目录:

#-----------configrs

#建立数据节点data和日志目录

mkdir -p /mongodb/sharded_cluster/myconfigrs_27019/log \ &

mkdir -p /mongodb/sharded_cluster/myconfigrs_27019/data/db \ &

mkdir -p /mongodb/sharded_cluster/myconfigrs_27119/log \ &

mkdir -p /mongodb/sharded_cluster/myconfigrs_27119/data/db \ &

mkdir -p /mongodb/sharded_cluster/myconfigrs_27219/log \ &

mkdir -p /mongodb/sharded_cluster/myconfigrs_27219/data/db

2

3

4

5

6

7

8

9

10

新建或修改配置文件:

vim /mongodb/sharded_cluster/myconfigrs_27019/mongod.conf

myconfigrs_27019 :

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myconfigrs_27019/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myconfigrs_27019/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myconfigrs_27019/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27019

replication:

replSetName: myconfigrs

sharding:

clusterRole: configsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

新建或修改配置文件:

vim /mongodb/sharded_cluster/myconfigrs_27119/mongod.conf

myconfigrs_27119

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myconfigrs_27119/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myconfigrs_27119/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myconfigrs_27119/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27119

replication:

replSetName: myconfigrs

sharding:

clusterRole: configsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

新建或修改配置文件:

vim /mongodb/sharded_cluster/myconfigrs_27219/mongod.conf

myconfigrs_27219

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/myconfigrs_27219/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

storage:

#mongod实例存储其数据的目录。storage.dbPath设置仅适用于mongod。

dbPath: "/mongodb/sharded_cluster/myconfigrs_27219/data/db"

journal:

#启用或禁用持久性日志以确保数据文件保持有效和可恢复。

enabled: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: "/mongodb/sharded_cluster/myconfigrs_27219/log/mongod.pid"

net:

#服务实例绑定所有IP

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#绑定的端口

port: 27219

replication:

replSetName: myconfigrs

sharding:

clusterRole: configsvr

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

启动配置副本集:一主两副本

依次启动三个mongod服务:

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myconfigrs_27019/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123223

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myconfigrs_27119/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123292

child process started successfully, parent exiting

[root@bobohost bin]# /usr/local/mongodb/bin/mongod -f /mongodb/sharded_cluster/myconfigrs_27219/mongod.conf

about to fork child process, waiting until server is ready for connections.

forked process: 123326

child process started successfully, parent exiting

2

3

4

5

6

7

8

9

10

11

12

13

14

查看服务是否启动:

[root@bobohost bin]# ps -ef |grep mongod

# 2.5.1 初始化副本集和创建主节点

使用客户端命令连接任意一个节点,但这里尽量要连接主节点:

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27019

执行初始化副本集命令:

rs.initiate()

查看副本集情况 (节选内容):

rs.status()

主节点配置查看:

rs.conf()

# 2.5.2 添加两个副本节点

myshardrs01:PRIMARY> rs.add("180.76.159.126:27119")

myshardrs01:PRIMARY> rs.add("180.76.159.126:27219")

2

查看副本集的配置情况:

myshardrs01:PRIMARY> rs.conf()

myshardrs01:PRIMARY> rs.status()

2

# 2.6 路由节点的创建和操作

# 2.6.1 第一个路由节点的创建和连接

第一步:准备存放数据和日志的目录:

#-----------mongos01

mkdir -p /mongodb/sharded_cluster/mymongos_27017/log

2

mymongos_27017节点:

新建或修改配置文件:

vi /mongodb/sharded_cluster/mymongos_27017/mongos.conf

mongos.conf:

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/mymongos_27017/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: /mongodb/sharded_cluster/mymongos_27017/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27017

sharding:

#指定配置节点副本集

configDB: myconfigrs/180.76.159.126:27019,180.76.159.126:27119,180.76.159.126:27219

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

启动mongos:

[root@bobohost bin]# /usr/local/mongodb/bin/mongos -f /mongodb/sharded_cluster/mymongos_27017/mongos.conf

about to fork child process, waiting until server is ready for connections.

forked process: 129874

child process started successfully, parent exiting

2

3

4

提示:启动如果失败,可以查看 log目录下的日志,查看失败原因。

客户端登录mongos

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27017

此时,写不进去数据,如果写数据会报错:

mongos> use aadb

switched to db aadb

mongos> db.aa.insert({aa:"aa"})

WriteCommandError({

"ok" : 0,

"errmsg" : "unable to initialize targeter for write op for collection aa.aa :: caused by :: Database aa not found :: caused by :: No shards found",

"code" : 70,

"codeName" : "ShardNotFound",

"operationTime" : Timestamp(1564600123, 2),

"$clusterTime" : {

"clusterTime" : Timestamp(1564600123, 2),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

})

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

原因:通过路由节点操作,现在只是连接了配置节点,还没有连接分片数据节点,因此无法写入业务数据。

# 2.6.2 在路由节点上进行分片配置操作

使用命令添加分片:

# 2.6.2.1 添加分片:

语法:

sh.addShard("IP:Port")

将第一套分片副本集添加进来:

mongos>sh.addShard("myshardrs01/192.168.0.2:27018,180.76.159.126:27118,180.76.159.126:27218")

{

"shardAdded" : "myshardrs01",

"ok" : 1,

"operationTime" : Timestamp(1564611970, 4),

"$clusterTime" : {

"clusterTime" : Timestamp(1564611970, 4),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

查看分片状态情况:

mongos> sh.status()

--- Sharding Status ---

sharding version: {

"_id" : 1,

"minCompatibleVersion" : 5,

"currentVersion" : 6,

"clusterId" : ObjectId("5d4211b798f3f9a48522c68b")

}

shards:

{ "_id" : "myshardrs01", "host" : "myshardrs01/180.76.159.126:27018,180.76.159.126:27118", "state" : 1 }

active mongoses:

"4.0.10" : 1

autosplit:

Currently enabled: yes

balancer:

Currently enabled: yes

Currently running: no

Failed balancer rounds in last 5 attempts: 0

Migration Results for the last 24 hours:

No recent migrations

databases:

{ "_id" : "config", "primary" : "config", "partitioned" : true }

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

继续将第二套分片副本集添加进来:

mongos>sh.addShard("myshardrs02/192.168.0.2:27318,180.76.159.126:27418,180.76.159.126:27518")

{

"shardAdded" : "myshardrs02",

"ok" : 1,

"operationTime" : Timestamp(1564612147, 5),

"$clusterTime" : {

"clusterTime" : Timestamp(1564612147, 5),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

查看分片状态:

mongos> sh.status()

--- Sharding Status ---

sharding version: {

"_id" : 1,

"minCompatibleVersion" : 5,

"currentVersion" : 6,

"clusterId" : ObjectId("5d4211b798f3f9a48522c68b")

}

shards:

{ "_id" : "myshardrs01", "host" : "myshardrs01/180.76.159.126:27018,180.76.159.126:27118", "state" : 1 }

{ "_id" : "myshardrs02", "host" : "myshardrs02/180.76.159.126:27318,180.76.159.126:27418", "state" : 1 }

active mongoses:

"4.0.10" : 1

autosplit:

Currently enabled: yes

balancer:

Currently enabled: yes

Currently running: no

Failed balancer rounds in last 5 attempts: 0

Migration Results for the last 24 hours:

No recent migrations

databases:

{ "_id" : "config", "primary" : "config", "partitioned" : true }

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

提示:如果添加分片失败,需要先手动移除分片,检查添加分片的信息的正确性后,再次添加分片。

移除分片参考(了解):

use admin

db.runCommand( { removeShard: "myshardrs02" } )

2

注意:如果只剩下最后一个 shard,是无法删除的

移除时会自动转移分片数据,需要一个时间过程。

完成后,再次执行删除分片命令才能真正删除。

# 2.6.2.2 开启分片功能

sh.enableSharding(“库名”)、sh.shardCollection(“库名.集合名”,{“key”:1})

在mongos上的articledb数据库配置sharding:

mongos> sh.enableSharding("articledb")

{

"ok" : 1,

"operationTime" : Timestamp(1564612296, 5),

"$clusterTime" : {

"clusterTime" : Timestamp(1564612296, 5),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

查看分片状态:

mongos> sh.status()

--- Sharding Status ---

sharding version: {

"_id" : 1,

"minCompatibleVersion" : 5,

"currentVersion" : 6,

"clusterId" : ObjectId("5d4211b798f3f9a48522c68b")

}

shards:

{ "_id" : "myshardrs01", "host" : "myshardrs01/180.76.159.126:27018,180.76.159.126:27118", "state" : 1 }

{ "_id" : "myshardrs02", "host" : "myshardrs02/180.76.159.126:27318,180.76.159.126:27418", "state" : 1 }

active mongoses:

"4.0.10" : 1

autosplit:

Currently enabled: yes

balancer:

Currently enabled: yes

Currently running: no

Failed balancer rounds in last 5 attempts: 0

Migration Results for the last 24 hours:

No recent migrations

databases:

{ "_id" : "articledb", "primary" : "myshardrs02", "partitioned" : true, "version" : { "uuid" : UUID("788c9a3b-bb6a-4cc2-a597-974694772986"), "lastMod" : 1 } }

{ "_id" : "config", "primary" : "config", "partitioned" : true }

config.system.sessions

shard key: { "_id" : 1 }

unique: false

balancing: true

chunks:

myshardrs01 1

{ "_id" : { "$minKey" : 1 } } -->> { "_id" : { "$maxKey" : 1 } } on : myshardrs01 Timestamp(1, 0)

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

# 2.6.2.3 集合分片

对集合分片,你必须使用 sh.shardCollection() 方法指定集合和分片键

语法:

sh.shardCollection(namespace, key, unique)

参数:

| Parameter | Type | Description |

|---|---|---|

| namespace | string | 要(分片)共享的目标集合的命名空间,格式: . |

| key | document | 用作分片键的索引规范文档。shard键决定MongoDB如何在shard之间分发文档。除非集合为空,否则索引必须在shardcollection命令之前存在。如果集合为空,则MongoDB在对集合进行分片之前创建索引,前提是支持分片键的索引不存在。简单的说:由包含字段和该字段的索引遍历方向的文档组成。 |

| unique | boolean | 当值为true情况下,片键字段上会限制为确保是唯一索引。哈希策略片键不支持唯一索引。默认是false。 |

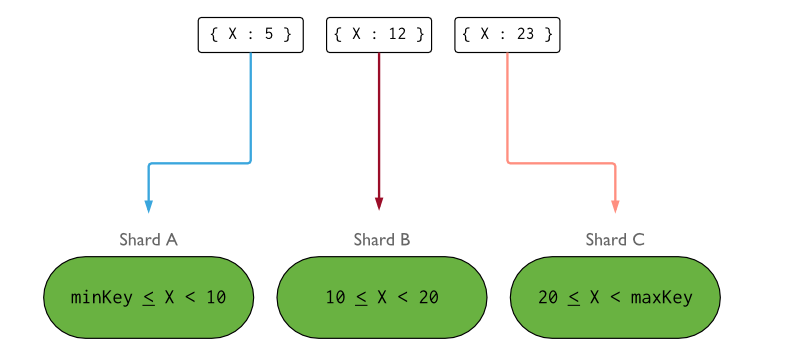

对集合进行分片时,你需要选择一个 片键(Shard Key) , shard key 是每条记录都必须包含的,且建立了索引的单个字段或复合字段,MongoDB按照片键将数据划分到不同的 数据块 中,并将 数据块 均衡地分布到所有分片中.为了按照片键划分数据块,MongoDB使用 基于哈希的分片方式(随机平均分配)或者基于范围的分片方式(数值大小分配) 。

用什么字段当片键都可以,如:nickname作为片键,但一定是必填字段。

分片规则一:哈希策略

对于 基于哈希的分片 ,MongoDB计算一个字段的哈希值,并用这个哈希值来创建数据块.

在使用基于哈希分片的系统中,拥有”相近”片键的文档 很可能不会 存储在同一个数据块中,因此数据的分离性更好一些.

使用nickname作为片键,根据其值的哈希值进行数据分片

mongos> sh.shardCollection("articledb.comment",{"nickname":"hashed"})

{

"collectionsharded" : "articledb.comment",

"collectionUUID" : UUID("ddea6ed8-ee61-4693-bd16-196acc3a45e8"),

"ok" : 1,

"operationTime" : Timestamp(1564612840, 28),

"$clusterTime" : {

"clusterTime" : Timestamp(1564612840, 28),

"signature" : {

"hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

"keyId" : NumberLong(0)

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

查看分片状态:sh.status()

databases:

{ "_id" : "articledb", "primary" : "myshardrs02", "partitioned" : true, "version" : { "uuid" : UUID("251436b7-86c2-4cd8-9a88-70874af29364"), "lastMod" : 1 } }

articledb.comment

shard key: { "nickname" : "hashed" }

unique: false

balancing: true

chunks:

myshardrs01 2

myshardrs02 2

{ "nickname" : { "$minKey" : 1 } } -->> { "nickname" : NumberLong("-4611686018427387902") } on : myshardrs01 Timestamp(1, 0)

{ "nickname" : NumberLong("-4611686018427387902") } -->> { "nickname" : NumberLong(0) } on : myshardrs01 Timestamp(1, 1)

{ "nickname" : NumberLong(0) } -->> { "nickname" : NumberLong("4611686018427387902") } on : myshardrs02 Timestamp(1, 2)

{ "nickname" : NumberLong("4611686018427387902") } -->> { "nickname" : { "$maxKey" : 1 } } on : myshardrs02 Timestamp(1, 3)

{ "_id" : "config", "primary" : "config", "partitioned" : true }

config.system.sessions

shard key: { "_id" : 1 }

unique: false

balancing: true

chunks:

myshardrs01 1

{ "_id" : { "$minKey" : 1 } } -->> { "_id" : { "$maxKey" : 1 } } on : myshardrs01 Timestamp(1, 0)

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

分片规则二:范围策略

对于 基于范围的分片 ,MongoDB按照片键的范围把数据分成不同部分.假设有一个数字的片键:想象一个从负无穷到正无穷的直线,每一个片键的值都在直线上画了一个点.MongoDB把这条直线划分为更短的不重叠的片段,并称之为 数据块 ,每个数据块包含了片键在一定范围内的数据.

在使用片键做范围划分的系统中,拥有”相近”片键的文档很可能存储在同一个数据块中,因此也会存储在同一个分片中.

如使用作者年龄字段作为片键,按照点赞数的值进行分片:

mongos> sh.shardCollection("articledb.author",{"age":1})

{

"collectionsharded" : "articledb.author",

"collectionUUID" : UUID("9a47bdaa-213a-4039-9c18-e70bfc369df7"),

"ok" : 1,

"operationTime" : Timestamp(1567512803, 13),

"$clusterTime" : {

"clusterTime" : Timestamp(1567512803, 13),

"signature" : {

"hash" : BinData(0,"eE9QT5yE5sL1Tyr7+3U8GRy5+5Q="),

"keyId" : NumberLong("6732061237309341726")

}

}

}

2

3

4

5

6

7

8

9

10

11

12

13

14

注意的是:

- 一个集合只能指定一个片键,否则报错。

- 一旦对一个集合分片,分片键和分片值就不可改变。 如:不能给集合选择不同的分片键、不能更新分片键的值。

- 根据age索引进行分配数据。

查看分片状态:

articledb.author

shard key: { "age" : 1 }

unique: false

balancing: true

chunks:

myshardrs01 1

{ "age" : { "$minKey" : 1 } } -->> { "age" : { "$maxKey" : 1 } } on : myshardrs01 Timestamp(1, 0)

2

3

4

5

6

7

基于范围的分片方式与基于哈希的分片方式性能对比:

基于范围的分片方式提供了更高效的范围查询,给定一个片键的范围,分发路由可以很简单地确定哪个数据块存储了请求需要的数据,并将请求转发到相应的分片中.

不过,基于范围的分片会导致数据在不同分片上的不均衡,有时候,带来的消极作用会大于查询性能的积极作用.比如,如果片键所在的字段是线性增长的,一定时间内的所有请求都会落到某个固定的数据块中,最终导致分布在同一个分片中.在这种情况下,一小部分分片承载了集群大部分的数据,系统并不能很好地进行扩展.

与此相比,基于哈希的分片方式以范围查询性能的损失为代价,保证了集群中数据的均衡.哈希值的随机性使数据随机分布在每个数据块中,因此也随机分布在不同分片中.但是也正由于随机性,一个范围查询很难确定应该请求哪些分片,通常为了返回需要的结果,需要请求所有分片.

如无特殊情况,一般推荐使用 Hash Sharding。

而使用 _id 作为片键是一个不错的选择,因为它是必有的,你可以使用数据文档 _id 的哈希作为片键。

这个方案能够是的读和写都能够平均分布,并且它能够保证每个文档都有不同的片键所以数据块能够很精细。

似乎还是不够完美,因为这样的话对多个文档的查询必将命中所有的分片。虽说如此,这也是一种比较好的方案了。

理想化的 shard key 可以让 documents 均匀地在集群中分布:

显示集群的详细信息:

mongos> db.printShardingStatus()

查看均衡器是否工作(需要重新均衡时系统才会自动启动,不用管它):

mongos> sh.isBalancerRunning()

false

2

查看当前 Balancer状态:

mongos> sh.getBalancerState()

true

2

# 2.6.3 分片后插入数据测试

测试一(哈希规则):登录mongs后,向comment循环插入1000条数据做测试:

mongos> use articledb

switched to db articledb

mongos> for(var i=1;i<=1000;i++){db.comment.insert({_id:i+"",nickname:"BoBo"+i})}

WriteResult({ "nInserted" : 1 })

mongos> db.comment.count()

1000

2

3

4

5

6

提示: js的语法,因为mongo的shell是一个JavaScript的shell。

注意:从路由上插入的数据,必须包含片键,否则无法插入。

分别登陆两个片的主节点,统计文档数量

第一个分片副本集:

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27018

myshardrs01:PRIMARY> use articledb

switched to db articledb

myshardrs01:PRIMARY> db.comment.count()

507

2

3

4

5

6

第二个分片副本集:

/usr/local/mongodb/bin/mongo --host 180.76.159.126 --port 27318

myshardrs02:PRIMARY> use articledb

switched to db articledb

myshardrs02:PRIMARY> db.comment.count()

493

2

3

4

5

6

可以看到, 1000条数据近似均匀的分布到了2个shard上。是根据片键的哈希值分配的。

这种分配方式非常易于水平扩展:一旦数据存储需要更大空间,可以直接再增加分片即可,同时提升了性能。

使用db.comment.stats()查看单个集合的完整情况,mongos执行该命令可以查看该集合的数据分片的情况。

使用sh.status()查看本库内所有集合的分片信息。

测试二(范围规则):登录mongs后,向comment循环插入1000条数据做测试:

mongos> use articledb

switched to db articledb

mongos> for(var i=1;i<=20000;i++){db.author.save({"name":"BoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBoBo"+i,"age":NumberInt(i%120)})}

WriteResult({ "nInserted" : 1 })

mongos> db.comment.count()

20000

2

3

4

5

6

插入成功后,仍然要分别查看两个分片副本集的数据情况。

分片效果:

articledb.author

shard key: { "age" : 1 }

unique: false

balancing: true

chunks:

myshardrs01 2

myshardrs02 1

{ "age" : { "$minKey" : 1 } } -->> { "age" : 0 } on : myshardrs02 Timestamp(2, 0)

{ "age" : 0 } -->> { "age" : 112 } on : myshardrs01 Timestamp(2, 1)

{ "age" : 112 } -->> { "age" : { "$maxKey" : 1 } } on : myshardrs01 Timestamp(1, 3)

2

3

4

5

6

7

8

9

10

提示:

如果查看状态发现没有分片,则可能是由于以下原因造成了:

系统繁忙,正在分片中。

数据块(chunk)没有填满,默认的数据块尺寸(chunksize)是64M,填满后才会考虑向其他片的数据块填充数据,因此,为了测试,可以将其改小,这里改为1M,操作如下:

use config db.settings.save( { _id:"chunksize", value: 1 } )1

2测试完改回来:

db.settings.save( { _id:"chunksize", value: 64 } )1

注意:要先改小,再设置分片。为了测试,可以先删除集合,重新建立集合的分片策略,再插入数据测试即可。

# 2.6.4 再增加一个路由节点

文件夹:

#-----------mongos02

mkdir -p /mongodb/sharded_cluster/mymongos_27117/log

2

新建或修改配置文件:

vi /mongodb/sharded_cluster/mymongos_27117/mongos.conf

mongos.conf:

systemLog:

#MongoDB发送所有日志输出的目标指定为文件

destination: file

#mongod或mongos应向其发送所有诊断日志记录信息的日志文件的路径

path: "/mongodb/sharded_cluster/mymongos_27117/log/mongod.log"

#当mongos或mongod实例重新启动时,mongos或mongod会将新条目附加到现有日志文件的末尾。

logAppend: true

processManagement:

#启用在后台运行mongos或mongod进程的守护进程模式。

fork: true

#指定用于保存mongos或mongod进程的进程ID的文件位置,其中mongos或mongod将写入其PID

pidFilePath: /mongodb/sharded_cluster/mymongos_27117/log/mongod.pid"

net:

#服务实例绑定所有IP,有副作用,副本集初始化的时候,节点名字会自动设置为本地域名,而不是ip

#bindIpAll: true

#服务实例绑定的IP

bindIp: localhost,192.168.0.2

#bindIp

#绑定的端口

port: 27117

sharding:

configDB: myconfigrs/180.76.159.126:27019,180.76.159.126:27119,180.76.159.126:27219

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

启动mongos2:

[root@bobohost bin]# /usr/local/mongodb/bin/mongos -f /mongodb/sharded_cluster/mymongos_27117/mongos.conf

about to fork child process, waiting until server is ready for connections.

forked process: 129874

child process started successfully, parent exiting

2

3

4

使用mongo客户端登录27117,发现,第二个路由无需配置,因为分片配置都保存到了配置服务器中了。

# 2.7 Compass 连接分片集群

compass连接:

提示:和连接单机 mongod一样。

连接成功后,上方有mongos和分片集群的提示:

# 2.8 SpringDataMongDB 连接分片集群

Java客户端常用的是SpringDataMongoDB,其连接的是mongs路由,配置和单机mongod的配置是一样的。

多个路由的时候的SpringDataMongoDB的客户端配置参考如下:

spring:

#数据源配置

data:

mongodb:

# 主机地址

# host: 180.76.159.126

# 数据库

# database: articledb

# 默认端口是27017

# port: 27017

#也可以使用uri连接

# uri: mongodb://192.168.40.134:28017/articledb

# 连接副本集字符串

# uri: mongodb://180.76.159.126:27017,180.76.159.126:27018,180.76.159.126:27019/articledb?connect=replicaSet&slaveOk=true&replicaSet=myrs

#连接路由字符串

uri: mongodb://180.76.159.126:27017,180.76.159.126:27117/articledb

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

通过日志发现,写入数据的时候,会选择一个路由写入

# 2.9 清除所有的节点数据(备用)

如果在搭建分片的时候有操作失败或配置有问题,需要重新来过的,可以进行如下操作:

第一步:查询出所有的测试服务节点的进程:

[root@bobohost sharded_cluster]# ps -ef |grep mongo